Cadrul NVIDIA NeMo

Specificații

- Numele produsului: Cadrul NVIDIA NeMo

- Platforme afectate: Windows, Linux, macOS

- Versiuni afectate: Toate versiunile anterioare 24

- Vulnerabilitatea de securitate: CVE-2025-23360

- Scorul de bază al evaluării riscurilor: 7.1 (CVSS v3.1)

Instrucțiuni de utilizare a produsului

Instalarea actualizării de securitate:

Pentru a vă proteja sistemul, urmați acești pași:

- Descărcați cea mai recentă versiune de pe pagina NeMo-Framework-Launcher Releases de pe GitHub.

- Accesați NVIDIA Product Security pentru mai multe informații.

Detalii de actualizare de securitate:

Actualizarea de securitate abordează o vulnerabilitate din cadrul NVIDIA NeMo, care ar putea duce la executarea codului și a datelor tampering.

Upgrade de software:

Dacă utilizați o versiune anterioară a ramurilor, se recomandă să faceți upgrade la cea mai recentă versiune ramificată pentru a rezolva problema de securitate.

Pesteview

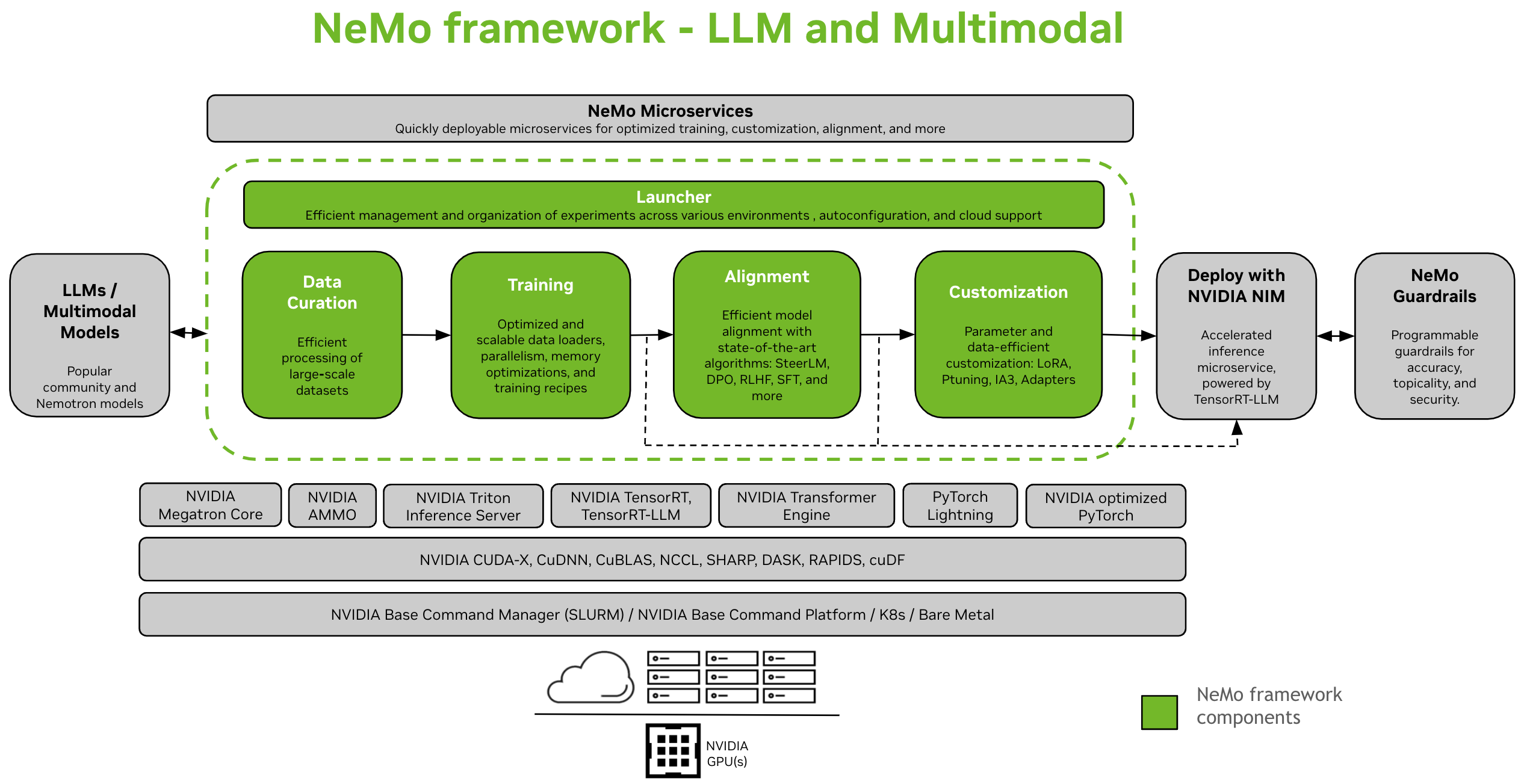

NVIDIA NeMo Framework este un cadru AI generativ scalabil și nativ din cloud, creat pentru cercetătorii și dezvoltatorii care lucrează la Modele de limbaj mari, Multimodal și AI vorbire (de ex Recunoaștere automată a vorbirii şi Text-to-Speech). Permite utilizatorilor să creeze, să personalizeze și să implementeze în mod eficient noi modele generative de IA prin valorificarea codului existent și a punctelor de control ale modelului pre-antrenate.

Instrucțiuni de configurare: Instalați NeMo Framework

NeMo Framework oferă suport end-to-end pentru dezvoltarea de modele de limbaj mari (LLM) și modele multimodale (MMs). Oferă flexibilitatea de a fi utilizat la nivel local, într-un centru de date sau cu furnizorul dvs. de cloud preferat. De asemenea, acceptă execuția în medii SLURM sau Kubernetes activate.

Curatarea datelor

Curator NeMo [1] este o bibliotecă Python care include o suită de module pentru extragerea datelor și generarea de date sintetice. Acestea sunt scalabile și optimizate pentru GPU-uri, făcându-le ideale pentru curatarea datelor în limbaj natural pentru a antrena sau a ajusta LLM-uri. Cu NeMo Curator, puteți extrage eficient text de înaltă calitate dintr-un raw extins web surse de date.

Instruire și personalizare

NeMo Framework oferă instrumente pentru formarea eficientă și personalizarea LLM-uri și modele multimodale. Include configurații implicite pentru configurarea clusterului de calcul, descărcarea datelor și hiperparametrii modelului, care pot fi ajustați pentru a se instrui pe noi seturi de date și modele. Pe lângă antrenamentul prealabil, NeMo acceptă atât tehnicile Supervised Fine-Tuning (SFT) și Parameter Efficient Fine-Tuning (PEFT), precum LoRA, Ptuning și multe altele.

Sunt disponibile două opțiuni pentru a lansa instruirea în NeMo – folosind interfața API NeMo 2.0 sau cu NeMo Run.

- Cu NeMo Run (recomandat): NeMo Run oferă o interfață pentru a simplifica configurarea, execuția și gestionarea experimentelor în diferite medii de calcul. Aceasta include lansarea de joburi pe stația dvs. de lucru local sau pe clustere mari - atât SLURM activat, cât și Kubernetes într-un mediu cloud.

- Pre-antrenament și PEFT Quickstart cu NeMo Run

- Folosind API-ul NeMo 2.0: Această metodă funcționează bine cu o configurare simplă care implică modele mici sau dacă sunteți interesat să vă scrieți propriul încărcător de date personalizat, bucle de antrenament sau să schimbați straturile de model. Vă oferă mai multă flexibilitate și control asupra configurațiilor și facilitează extinderea și personalizarea configurațiilor în mod programatic.

-

Trainițiind Quickstart cu NeMo 2.0 API

-

Migrarea de la NeMo 1.0 la NeMo 2.0 API

-

Aliniere

- NeMo-Aligner [1] este un set de instrumente scalabil pentru alinierea eficientă a modelului. Setul de instrumente are suport pentru algoritmi de aliniere a modelelor de ultimă generație, cum ar fi SteerLM, DPO, Reinforcement Learning from Human Feedback (RLHF) și multe altele. Acești algoritmi permit utilizatorilor să alinieze modelele lingvistice pentru a fi mai sigure, mai inofensive și mai utile.

- Toate punctele de control NeMo-Aligner sunt compatibile încrucișat cu ecosistemul NeMo, permițând personalizarea suplimentară și implementarea inferenței.

Flux de lucru pas cu pas al tuturor celor trei faze ale RLHF pe un model GPT-2B mic:

- Instruire SFT

- Recompensați formarea modelului

- Instruire PPO

În plus, demonstrăm suport pentru diverse alte metode noi de aliniere:

- DPO: un algoritm de aliniere ușor în comparație cu RLHF cu o funcție de pierdere mai simplă.

- Auto-play Reglare fină (SPIN)

- SteerLM: o tehnică bazată pe SFT condiționat, cu ieșire orientabilă.

Consultați documentația pentru mai multe informații: Documentația de aliniere

Modele multimodale

- NeMo Framework oferă software optimizat pentru a antrena și a implementa modele multimodale de ultimă generație în mai multe categorii: modele de limbaj multimodal, fundamente de viziune-limbaj, modele text-to-image și, dincolo de generarea 2D, folosind câmpurile radiante neuronale (NeRF).

- Fiecare categorie este concepută pentru a răspunde nevoilor și progreselor specifice din domeniu, utilizând modele de ultimă generație pentru a gestiona o gamă largă de tipuri de date, inclusiv text, imagini și modele 3D.

Nota

Migrem suportul pentru modelele multimodale de la NeMo 1.0 la NeMo 2.0. Dacă doriți să explorați acest domeniu între timp, vă rugăm să consultați documentația pentru versiunea NeMo 24.07 (anterioră).

Desfășurare și inferență

NeMo Framework oferă diferite căi pentru inferența LLM, găzduind diferite scenarii de implementare și nevoi de performanță.

Implementați cu NVIDIA NIM

- NeMo Framework se integrează perfect cu instrumentele de implementare a modelelor la nivel de întreprindere prin NVIDIA NIM. Această integrare este alimentată de NVIDIA TensorRT-LLM, asigurând o inferență optimizată și scalabilă.

- Pentru mai multe informații despre NIM, vizitați NVIDIA website-ul.

Implementați cu TensorRT-LLM sau vLLM

- NeMo Framework oferă scripturi și API-uri pentru a exporta modele în două biblioteci optimizate pentru inferență, TensorRT-LLM și vLLM și pentru a implementa modelul exportat cu NVIDIA Triton Inference Server.

- Pentru scenariile care necesită performanță optimizată, modelele NeMo pot folosi TensorRT-LLM, o bibliotecă specializată pentru accelerarea și optimizarea inferenței LLM pe GPU-urile NVIDIA. Acest proces presupune convertirea modelelor NeMo într-un format compatibil cu TensorRT-LLM folosind modulul nemo.export.

- Implementarea LLM s-a terminatview

- Implementați modele de limbi mari NeMo cu NIM

- Implementați modele de limbaj mari NeMo cu TensorRT-LLM

- Implementați modele de limbaj mari NeMo cu vLLM

Modele acceptate

Modele de limbaj mari

| Modele de limbaj mari | Preformare și SFT | PEFT | Aliniere | FP8 Training Convergence | TRT/TRTLLM | Convertiți în și din față îmbrățișată | Evaluare |

|---|---|---|---|---|---|---|---|

| Lama3 8B/70B, Lama3.1 405B | Da | Da | x | Da (verificat parțial) | Da | ambele | Da |

| Mixtral 8x7B/8x22B | Da | Da | x | Da (neverificat) | Da | ambele | Da |

| Nemotron 3 8B | Da | x | x | Da (neverificat) | x | ambele | Da |

| Nemotron 4 340B | Da | x | x | Da (neverificat) | x | ambele | Da |

| Baichuan2 7B | Da | Da | x | Da (neverificat) | x | ambele | Da |

| ChatGLM3 6B | Da | Da | x | Da (neverificat) | x | ambele | Da |

| Gemma 2B/7B | Da | Da | x | Da (neverificat) | Da | ambele | Da |

| Gemma2 2B/9B/27B | Da | Da | x | Da (neverificat) | x | ambele | Da |

| Mamba2 130M/370M/780M/1.3B/2.7B/8B/ Hybrid-8B | Da | Da | x | Da (neverificat) | x | x | Da |

| Phi3 mini 4k | x | Da | x | Da (neverificat) | x | x | x |

| Qwen2 0.5B/1.5B/7B/72B | Da | Da | x | Da (neverificat) | Da | ambele | Da |

| StarCoder 15B | Da | Da | x | Da (neverificat) | Da | ambele | Da |

| StarCoder2 3B/7B/15B | Da | Da | x | Da (neverificat) | Da | ambele | Da |

| BERT 110M/340M | Da | Da | x | Da (neverificat) | x | ambele | x |

| T5 220M/3B/11B | Da | Da | x | x | x | x | x |

Modele de limbaj vizual

| Modele de limbaj vizual | Preformare și SFT | PEFT | Aliniere | FP8 Training Convergence | TRT/TRTLLM | Convertiți în și din față îmbrățișată | Evaluare |

|---|---|---|---|---|---|---|---|

| NeVA (LLaVA 1.5) | Da | Da | x | Da (neverificat) | x | Din | x |

| Llama 3.2 Vision 11B/90B | Da | Da | x | Da (neverificat) | x | Din | x |

| LLaVA Next (LLaVA 1.6) | Da | Da | x | Da (neverificat) | x | Din | x |

Modele de încorporare

| Încorporarea modelelor de limbaj | Preformare și SFT | PEFT | Aliniere | FP8 Training Convergence | TRT/TRTLLM | Convertiți în și din față îmbrățișată | Evaluare |

|---|---|---|---|---|---|---|---|

| SBERT 340M | Da | x | x | Da (neverificat) | x | ambele | x |

| Lamă 3.2 Încorporarea 1B | Da | x | x | Da (neverificat) | x | ambele | x |

Modele World Foundation

| Modele World Foundation | Post-antrenament | Inferență accelerată |

|---|---|---|

| Cosmos-1.0-Diffusion-Text2World-7B | Da | Da |

| Cosmos-1.0-Diffusion-Text2World-14B | Da | Da |

| Cosmos-1.0-Diffusion-Video2World-7B | În curând | În curând |

| Cosmos-1.0-Diffusion-Video2World-14B | În curând | În curând |

| Cosmos-1.0-Autoregresiv-4B | Da | Da |

| Cosmos-1.0-Autoregressive-Video2World-5B | În curând | În curând |

| Cosmos-1.0-Autoregresiv-12B | Da | Da |

| Cosmos-1.0-Autoregressive-Video2World-13B | În curând | În curând |

Nota

NeMo acceptă, de asemenea, pretraining atât pentru arhitecturi de difuzie, cât și pentru arhitecturi autoregresive text2world modele de fundație.

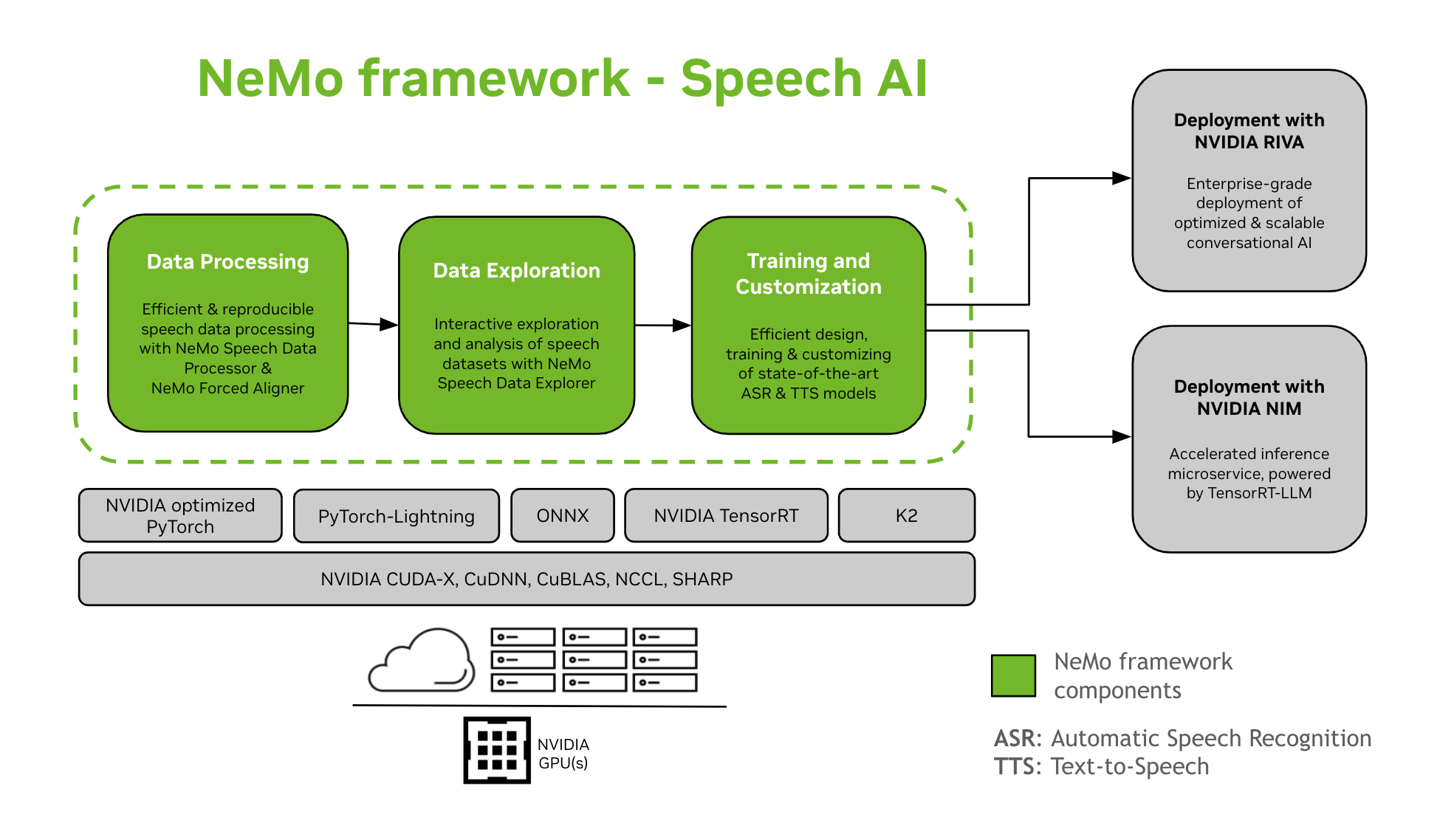

AI vorbire

Dezvoltarea modelelor AI conversaționale este un proces complex care implică definirea, construirea și antrenamentul modelelor în anumite domenii. Acest proces necesită de obicei mai multe iterații pentru a atinge un nivel ridicat de precizie. Adesea, implică mai multe iterații pentru a obține o acuratețe ridicată, reglarea fină a diferitelor sarcini și date specifice domeniului, asigurând performanța antrenamentului și pregătirea modelelor pentru implementarea inferenței.

NeMo Framework oferă suport pentru instruirea și personalizarea modelelor Speech AI. Aceasta include sarcini precum recunoașterea automată a vorbirii (ASR) și sinteza text-to-speech (TTS). Oferă o tranziție ușoară către implementarea producției la nivel de întreprindere cu NVIDIA Riva. Pentru a ajuta dezvoltatorii și cercetătorii, NeMo Framework include puncte de control pre-antrenate de ultimă generație, instrumente pentru procesarea datelor de vorbire reproductibilă și funcții pentru explorarea și analiza interactivă a seturilor de date privind vorbirea. Componentele cadrului NeMo pentru Speech AI sunt următoarele:

Instruire și personalizare

Cadrul NeMo conține tot ce este necesar pentru a antrena și personaliza modelele de vorbire (ASR, Clasificarea vorbirii, Recunoașterea vorbitorului, Diarizarea vorbitorului, și TTS) într-o manieră reproductibilă.

Modele SOTA Pre-antrenate

- NeMo Framework oferă rețete de ultimă generație și puncte de control pre-antrenate pentru mai multe ASR şi TTS modele, precum și instrucțiuni despre cum să le încărcați.

- Instrumente de vorbire

- NeMo Framework oferă un set de instrumente utile pentru dezvoltarea modelelor ASR și TTS, inclusiv:

- NeMo Forced Aligner (NFA) pentru generarea timpului la nivel de simbol, cuvânt și segmentamps de vorbire în audio folosind modelele NeMo de recunoaștere automată a vorbirii bazate pe CTC.

- Procesor de date de vorbire (SDP), un set de instrumente pentru simplificarea procesării datelor de vorbire. Vă permite să reprezentați operațiunile de prelucrare a datelor într-o config file, minimizând codul standard și permițând reproductibilitatea și partajarea.

- Speech Data Explorer (SDE), bazat pe Dash web aplicație pentru explorarea și analiza interactivă a seturilor de date de vorbire.

- Instrument de creare a seturilor de date care oferă funcționalitate pentru alinierea sunetului lung files cu transcrierile corespunzătoare și împărțiți-le în fragmente mai scurte care sunt potrivite pentru formarea modelului de recunoaștere automată a vorbirii (ASR).

- Instrument de comparație pentru modelele ASR pentru a compara predicțiile diferitelor modele ASR la nivel de acuratețe a cuvintelor și de enunț.

- Evaluator ASR pentru evaluarea performanței modelelor ASR și a altor caracteristici precum Detectarea activității vocale.

- Instrument de normalizare a textului pentru conversia textului din forma scrisă în forma vorbită și invers (de ex. „31” vs „treizeci întâi”).

- Calea către implementare

- Modelele NeMo care au fost instruite sau personalizate folosind cadrul NeMo pot fi optimizate și implementate cu NVIDIA Riva. Riva oferă containere și diagrame Helm special concepute pentru a automatiza pașii pentru implementarea butonului.

Alte resurse

- NeMo: Depozitul principal pentru NeMo Framework

- NeMo–Fugi: un instrument pentru a configura, lansa și gestiona experimentele de învățare automată.

- NeMo-Aligner: Set de instrumente scalabil pentru alinierea eficientă a modelului

- NeMo-curator: Setul de instrumente scalabil de preprocesare și curatare a datelor pentru LLM

Interacționează cu comunitatea NeMo, pune întrebări, obține asistență sau raportează erori.

- Discuții NeMo

- Probleme NeMo

Limbaje și cadre de programare

- Piton: Interfața principală pentru utilizarea NeMo Framework

- Pytorch: NeMo Framework este construit pe PyTorch

Licențe

- NeMo Github repo este licențiat sub licența Apache 2.0

- NeMo Framework este licențiat conform ACORDUL DE PRODUS NVIDIA AI. Prin tragerea și utilizarea containerului, acceptați termenii și condițiile acestei licențe.

- Containerul NeMo Framework conține materiale Llama reglementate de Acordul de licență comunitară Meta Llama3.

Note de subsol

În prezent, suportul NeMo Curator și NeMo Aligner pentru modelele multimodale este o lucrare în curs și va fi disponibil foarte curând.

FAQ

Î: Cum pot verifica dacă sistemul meu este afectat de vulnerabilitate?

R: Puteți verifica dacă sistemul dvs. este afectat verificând versiunea NVIDIA NeMo Framework instalată. Dacă este sub versiunea 24, sistemul dumneavoastră poate fi vulnerabil.

Î: Cine a raportat problema de securitate CVE-2025-23360?

R: Problema de securitate a fost raportată de Or Peles – JFrog Security. NVIDIA recunoaște contribuția lor.

Î: Cum pot primi notificări viitoare de buletine de securitate?

R: Vizitați pagina NVIDIA Product Security pentru a vă abona la notificările buletinului de securitate și pentru a fi la curent cu actualizările de securitate a produsului.

Documente/Resurse

|

Cadrul NVIDIA NeMo [pdfGhid de utilizare NeMo Framework, NeMo, Framework |